Google ColabでFlux LoRAモデルをトレーニングの実践手順紹介!

はじめに

Comfyuiで、LoRAモデルの重要性はますます高まっています。特にFluxモデルでのLoRAトレーニングは、個性的なキャラクターや独特なアーティスティックスタイルを再現するために欠かせない技術となっています。

私は自宅にRTX 5090を所有していますが、LoRAモデルのトレーニングにおいてGoogle Colabを選択している理由があります。RTX 5090は間違いなく強力なGPUですが、消費電力が非常に高く、長時間のトレーニングセッションでは電気代が気になります。さらに、数時間連続で動作させると発熱も相当なものになり、負荷が心配になります。

そこで、Google ColabのA100 GPUを活用することで、これらの問題を解決しながら効率的にLoRAモデルをトレーニングする方法をご紹介します。

Ⅰ:写真選択

数量15ー50

キャラクターLoRAの場合

キャラクターLoRAを作成する際の写真選択は、最終的な品質を決定する最も重要な要素の一つです。以下の基準を厳密に守ることで、原人物に非常に近いLoRAモデルを作成できます。

背景除去の重要性 まず、すべての写真から背景を完全に除去し、人物のみを残すことが重要です。背景が残っていると、モデルが人物の特徴ではなく背景の要素を学習してしまう可能性があります。この作業は手間がかかりますが、最終的な品質に大きく影響するため妥協できません。

comfyuiで背景を除去方法: https://shiokoto.com/archives/72

解像度とサイズの最適化 写真の解像度は可能な限り高品質を維持し、理想的には1024×1024ピクセルのサイズに統一します。これより小さいサイズでも訓練は可能ですが、あまりに小さすぎたりぼやけた写真は避けるべきです。解像度が低い写真を使用すると、生成される画像の品質も低下してしまいます。

多角度撮影の重要性 優れたLoRAモデルを作成するためには、様々な角度から撮影された写真が必要です。全身写真、半身写真、俯瞰アングル、仰視アングル、側面からの写真など、多様な視点の画像を含めることで、モデルはキャラクターの特徴をより包括的に学習できます。この多様性が、最終的に原人物に非常に近い仕上がりを実現する鍵となります。

スタイルLoRAの場合

スタイルLoRAを作成する際は、キャラクターLoRAとは異なるアプローチが必要です。この場合、特定のアーティスティックスタイルや視覚的特徴に焦点を当てます。重要なのは、対象となるスタイルの属性を明確に示す画像を選択し、適切なタグ付けを行うことです。スタイルLoRAでは、一貫した視覚的要素を持つ画像セットを用意し、そのスタイルを表現するキーワードを強化することが成功の鍵となります。

Ⅱ:タグ付けて、データセット

使用環境とタイミング

Google ColabでT4 GPUを使用する場合、タグ付けプロセスは通常5〜8分程度で完了します。

ステップバイステップの手順

以下のColabノートブックを使用してタグ付けを行います: https://colab.research.google.com/github/hollowstrawberry/kohya-colab/blob/main/Dataset_Maker.ipynb

1. プロジェクト名の設定と Drive 接続

最初に、プロジェクト名を明確に定義し、Google Driveとの連携を設定します。この段階で適切な命名規則を決めておくと、後の作業がスムーズに進みます。

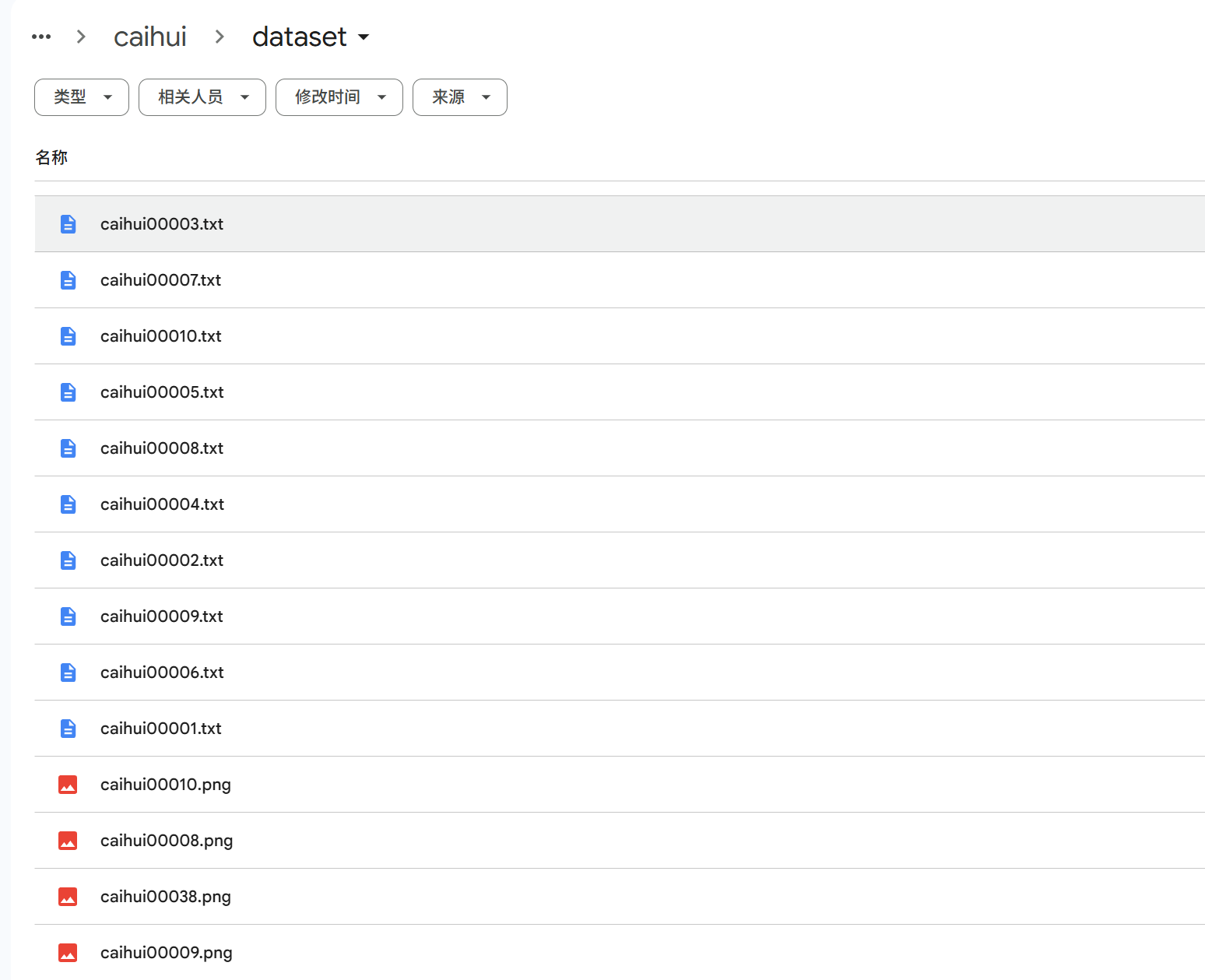

2. データセット準備

Drive接続が完了したら、準備した写真をdatasetフォルダにアップロードします。ファイルの整理は後の工程に大きく影響するため、体系的にアップロードすることをお勧めします。

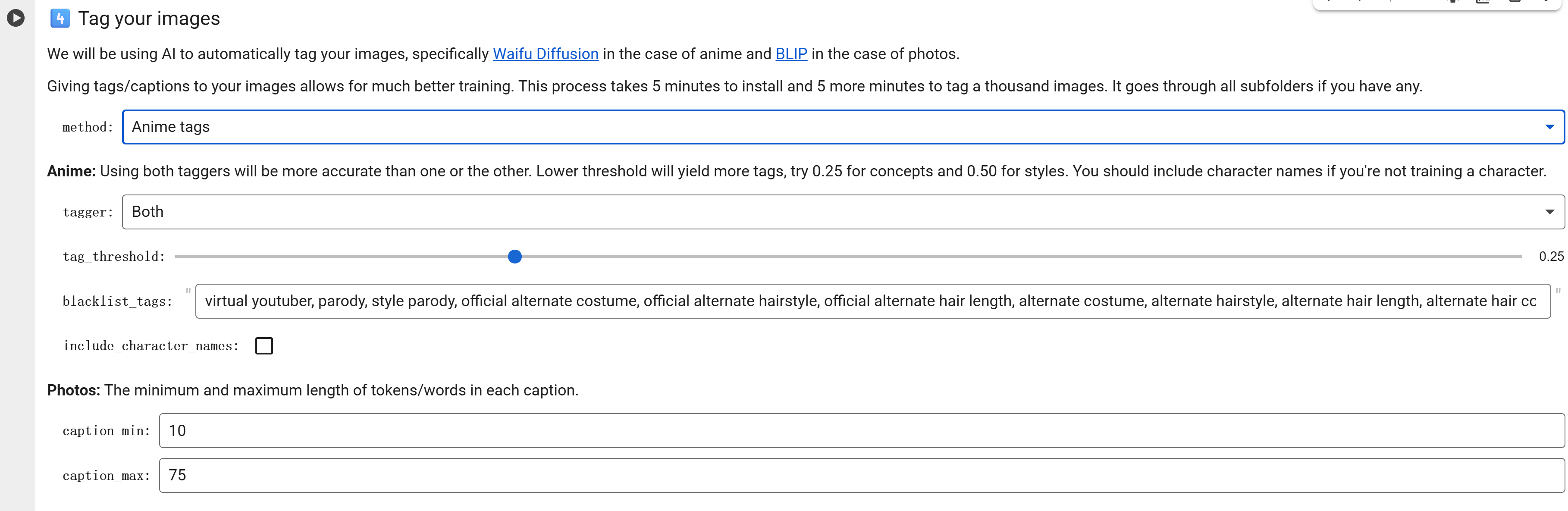

3. タグ付け手法の選択

method選択の重要性

- 実写の人物キャラクターの場合:「photo」を選択

- アニメキャラクターや風格化されたLoRAの場合:「anime」を選択

この選択は生成される画像の品質に直接影響するため、対象に応じて正確に設定する必要があります。

4. tag_thresholdの最適化

キャラクターLoRAを作成する際は、tag_thresholdの設定に特別な注意を払う必要があります:

- コンセプト(キャラクター)の場合:0.25

- スタイルの場合:0.50

この閾値設定により、適切な精度でタグが生成されます。

5. グローバルアクティベーションタグ

global_activation_tagには、LoRAを活性化するためのメインタグを入力します。このタグは、実際にモデルを使用する際のプロンプトで使用される重要な要素となります。

Ⅲ:トレーニング

環境

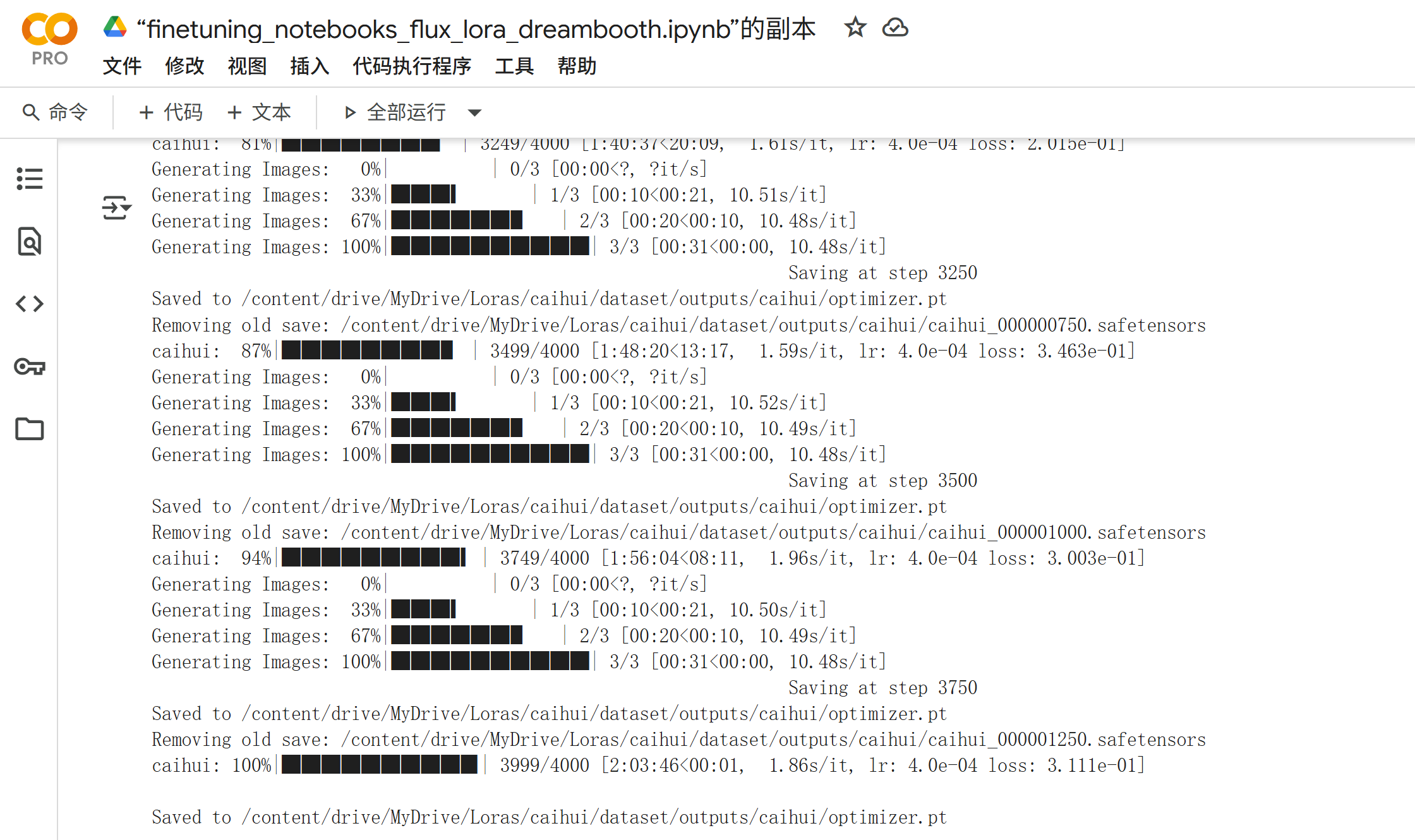

Google ColabのA100 GPUを使用する場合、デフォルト設定で約2時間でトレーニングが完了します。この処理速度は個人のGPU環境と比較して非常に効率的であり、電力コストも考慮すると極めて経済的です。

トレーニング手順

使用するノートブック https://github.com/jhj0517/finetuning-notebooks

このリポジトリは継続的にアップデートされており、最新のベストプラクティスが反映されています。

1. Drive接続の確立

まず、Google Driveとの接続を確立し、データセットへのアクセスを確保します。

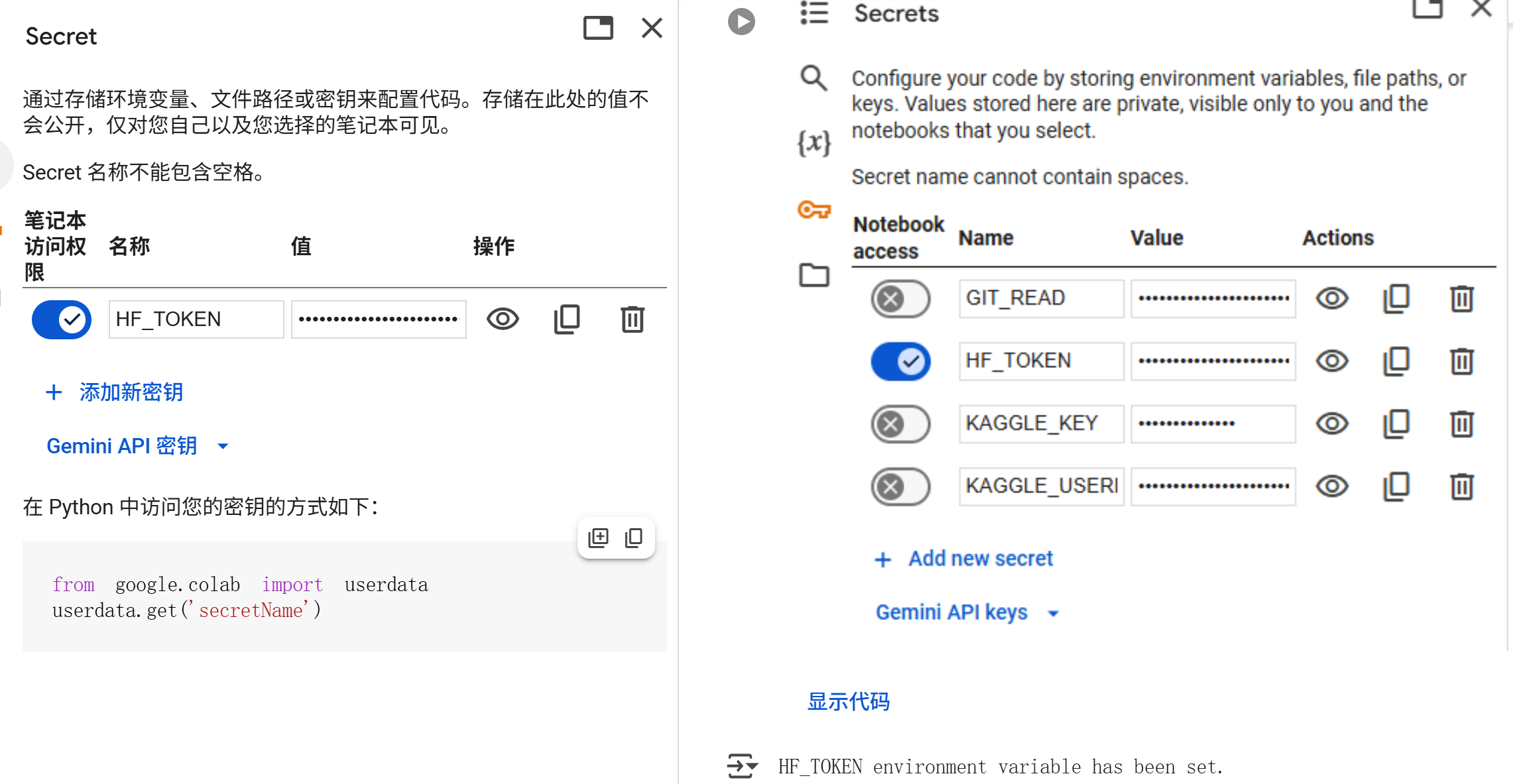

2. Hugging Face Token設定

モデルのダウンロードとアップロードのために、Hugging Face APIトークンを設定します。この設定により、モデルリポジトリへの適切なアクセスが可能になります。

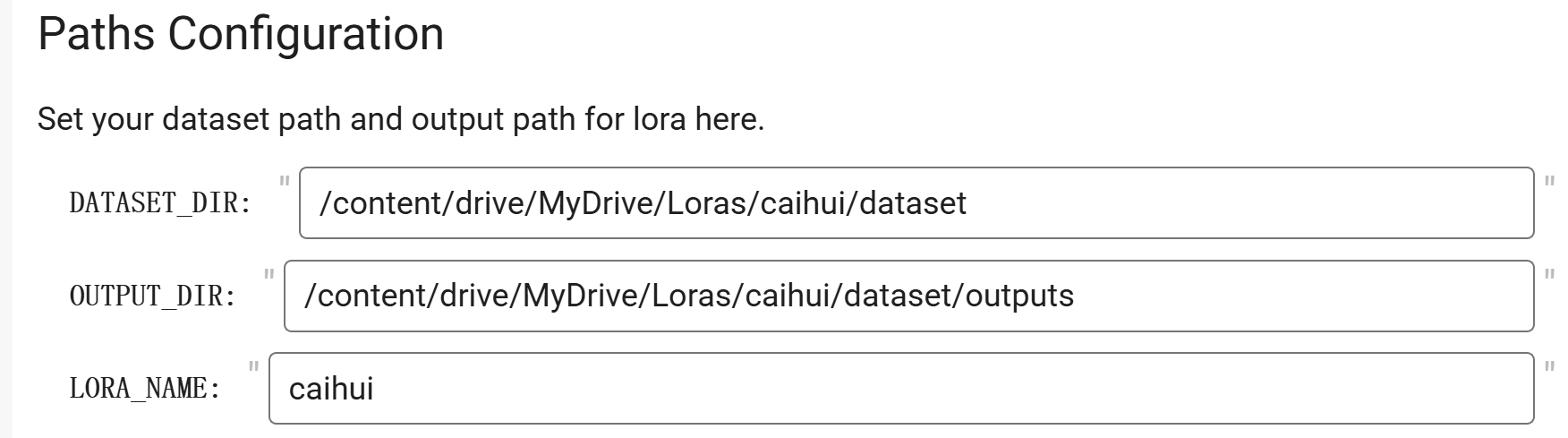

3. ディレクトリ構成の設定

先ほどタグ付けしたデータセットのディレクトリパスを正確に設定します。パスの設定ミスは訓練失敗の主要因となるため、慎重に確認する必要があります。

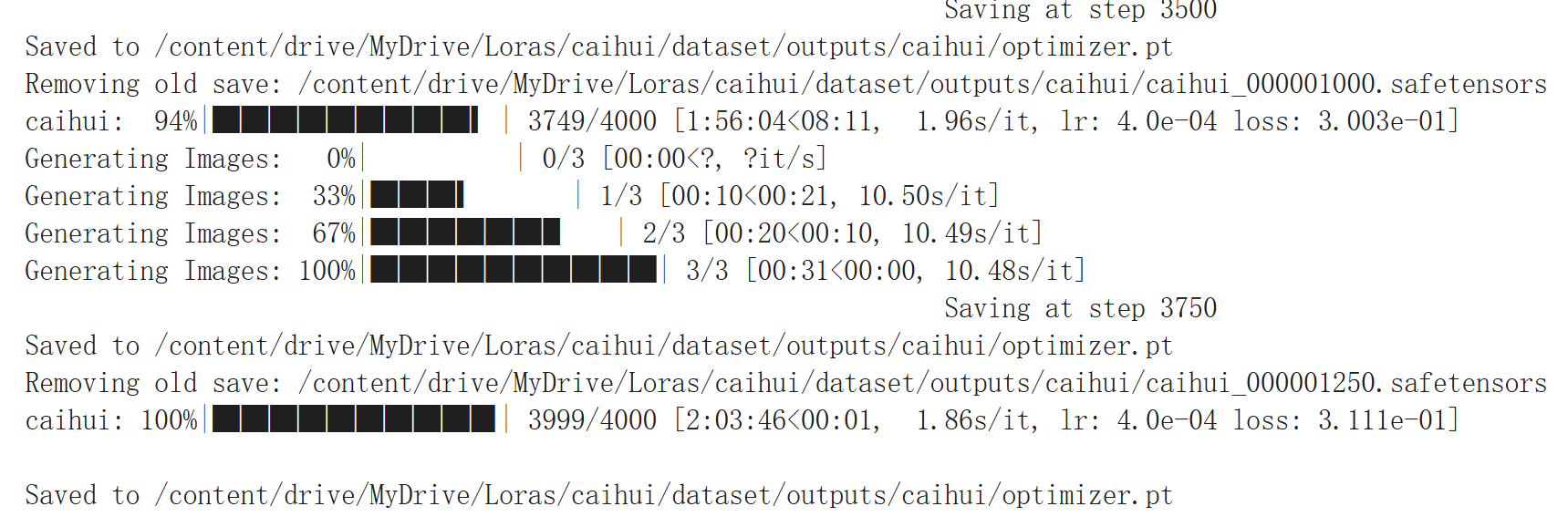

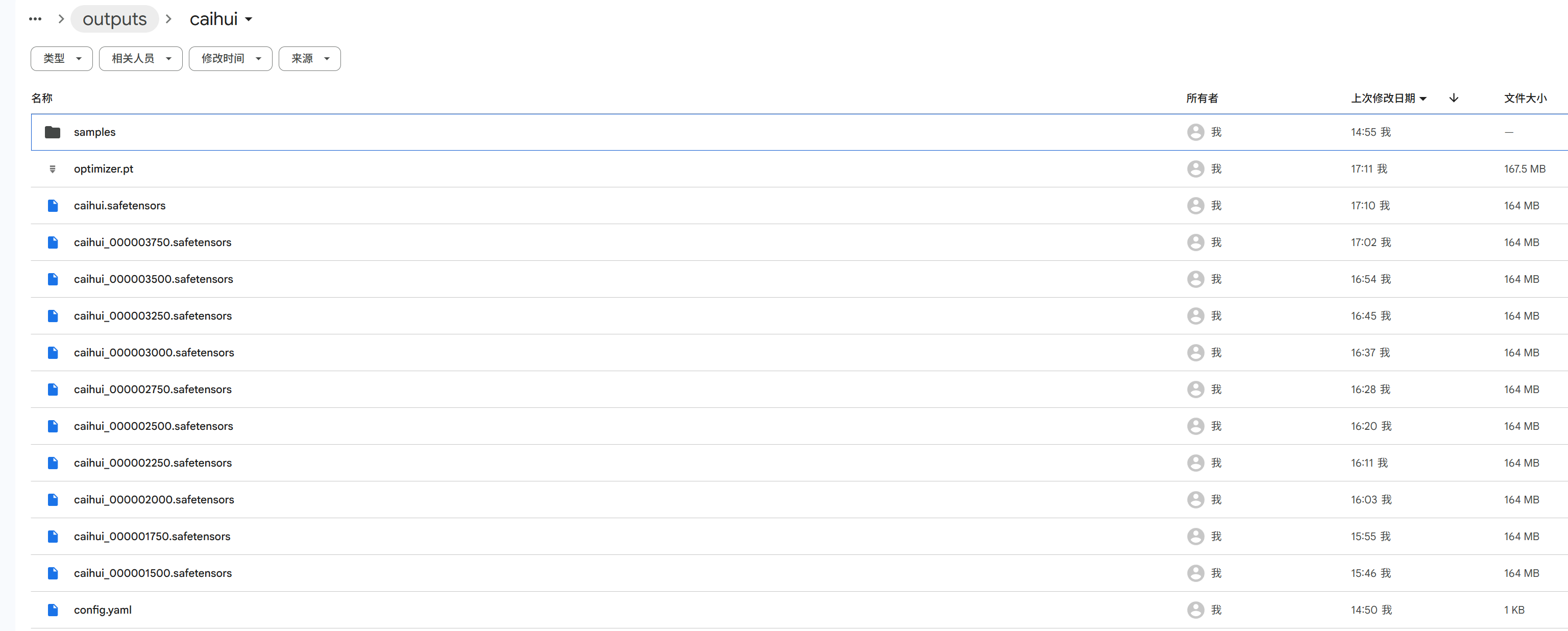

4. トレーニング開始

すべての設定が完了したら、トレーニングプロセスを開始します。A100 GPUの処理能力により、高品質なLoRAモデルが効率的に生成されます。約2時間でトレーニングが完了します。

Ⅳ:モデルの活用

パフォーマンス評価

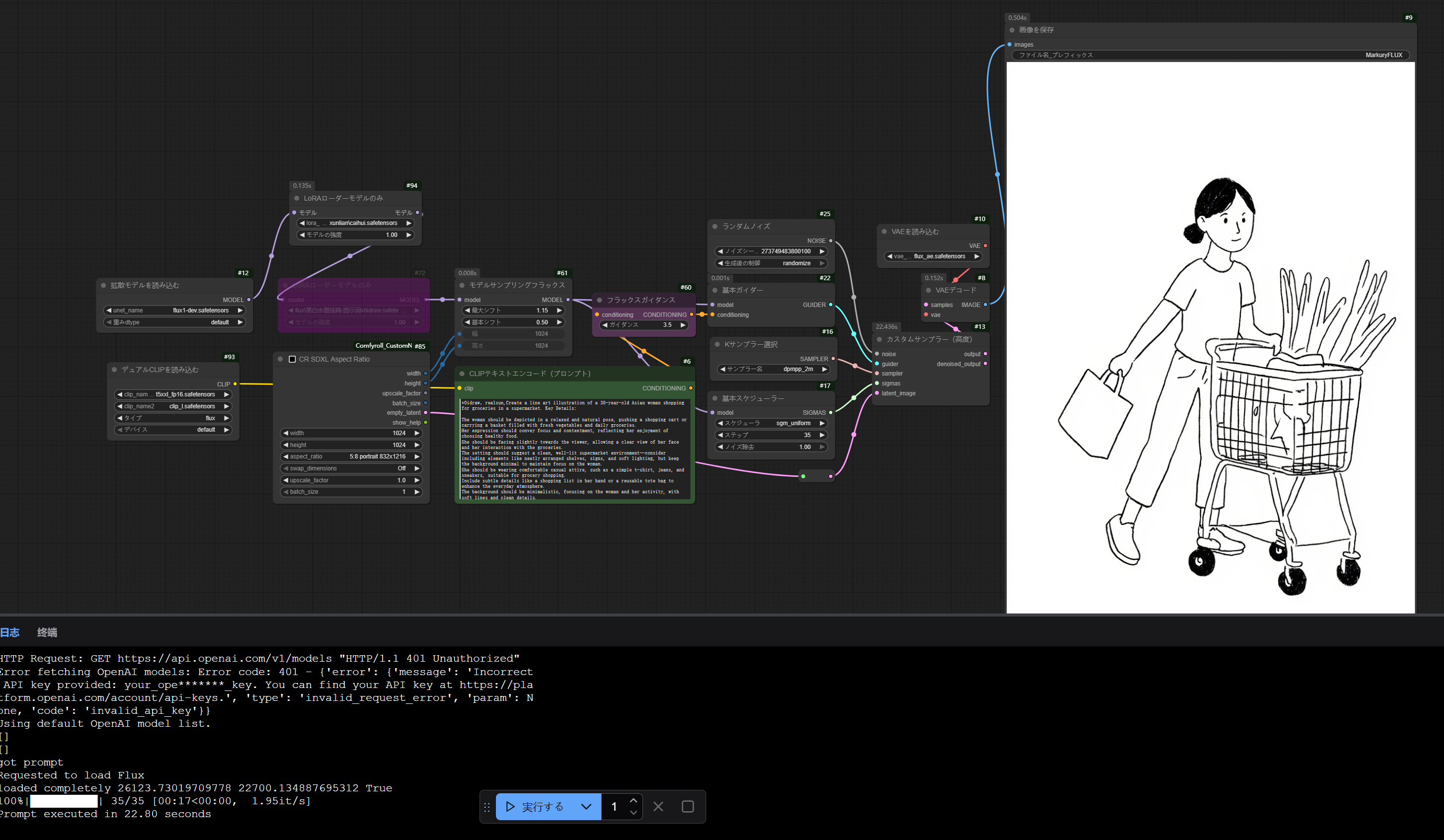

私のRTX 5090環境では、LoRAモデルを使用した画像生成が1枚あたり約15秒で完了します。この速度は実用的なワークフローを実現するのに十分であり、創作活動においてストレスを感じることはありません。

使用方法とワークフロー

訓練完了したLoRAモデルは、lorasディレクトリに配置して使用します。標準的なFlux + LoRAワークフローを採用することで、一貫して高品質な結果を得ることができます。

実際の使用体験

実際に使用してみると、トレーニングしたLoRAモデルの再現性は非常に高く、期待していた以上の品質を実現できています。特に、適切な写真選択とタグ付けプロセスを経た場合、原キャラクターの特徴を驚くほど正確に再現できます。

まとめ

この一連のプロセスを通じて、Google ColabでのFlux LoRAトレーニングは、個人GPU環境の代替として非常に有効であることが実証されました。特に以下の利点が顕著です:

コスト効率性 高性能GPUの長時間使用に伴う電気代を大幅に削減できます。

安定性 個人環境での発熱やシステム負荷を気にする必要がありません。

アクセシビリティ 最新のGPU技術を、ハードウェア投資なしで活用できます。

スケーラビリティ 必要に応じて処理能力を調整できる柔軟性があります。

RTX 5090のような高性能GPUを所有していても、用途と状況に応じてクラウドリソースを活用することで、より効率的で経済的なAI創作活動が実現できます。